独家、原创

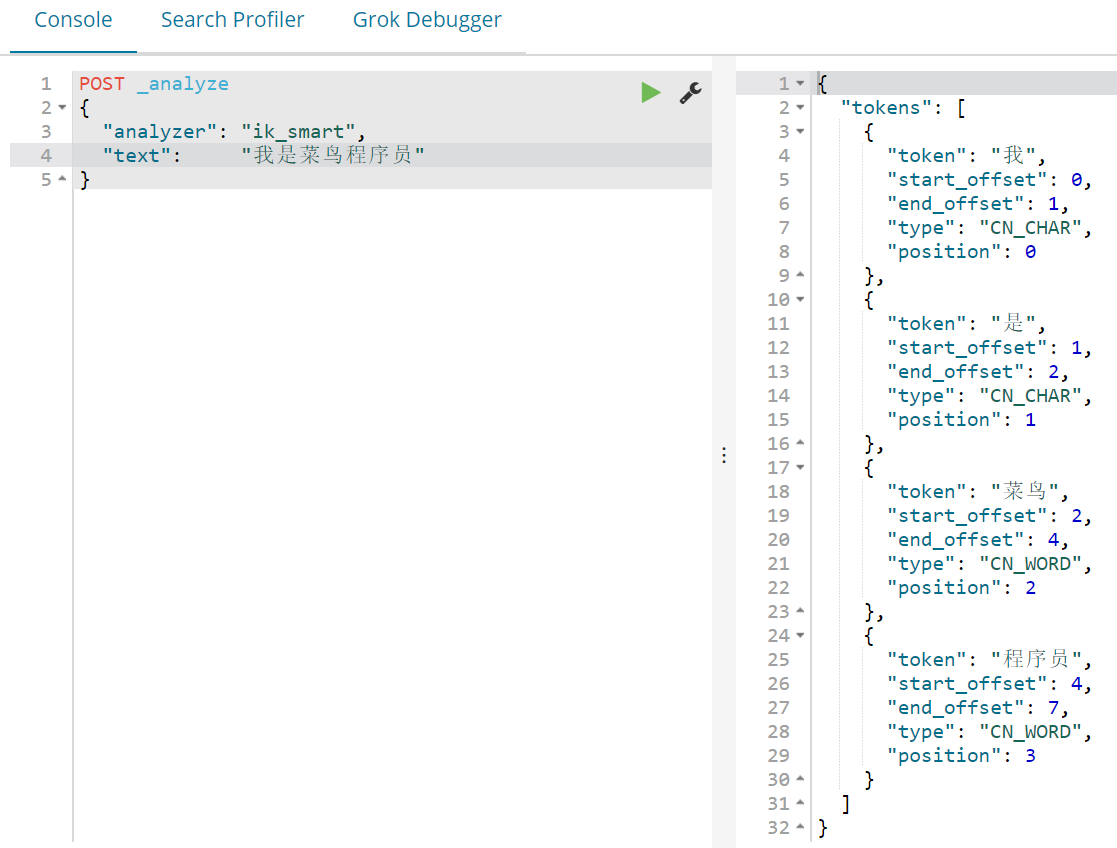

上篇完成了es和kabana 的挂载搭建、今天需要搭建一个中文分词器、

1、下载中文分词器

解压包——需要需要支付两元,因为在我的阿里云存

2、解压IK执行授权

chmod -R 777 ik/

3、分词器需要安装Nginx、前面教你安装过、在这里我在演示一下

3.1、docker pull nginx:1.10

3.2、先创建nginx目录

mider -p /mydata/nginx

3.3、创建个最简单的 nginx 目的是为了复制里面的配置文件

docker run -p 80:80 --name nginx -d nginx:1.10

3.4、复制容器的到宿主机

docker container cp nginx:/etc/nginx .

3.5、安装挂载到外面

docker run -p 80:80 --name nginx \ -v /mydata/nginx/html:/usr/share/nginx/html \ -v /mydata/nginx/logs:/rar/log/nginx \ -v /mydata/nginx/conf:/etc/nginx \ -d mydata:1.10

3.5.1、创建几个目录

1)在 mydata/nginx/html 创建了index.html 外网访问测试一下

2)然后在html 里面创建 es目录、在vi fenci.txt 加入自己的特殊词语

特殊词语:我爱乔碧萝

3.5.2、配置分词路径

1)自定义分词路径下IKAnalyzer.cfg.xml

/mydata/elasticsearch/plugins/ik/config #在elasticsearch的目录插件里面新建ik文件夹、把下载的包放进来

2) vi IKAnalyzer.cfg.xml 修改下面的用户可以在这里配置远程扩展字典访问ip

<?xml version="1.0" encoding="UTF-8"?> <!DOCTYPE properties SYSTEM "http://java.sun.com/dtd/properties.dtd"> <properties> <comment>IK Analyzer 扩展配置</comment> <!--用户可以在这里配置自己的扩展字典 --> <entry key="ext_dict"></entry> <!--用户可以在这里配置自己的扩展停止词字典--> <entry key="ext_stopwords"></entry> <!--用户可以在这里配置远程扩展字典 --> <entry key="remote_ext_dict">http://47.101.179.26/es/fenci.txt</entry> <!--用户可以在这里配置远程扩展停止词字典--> <!-- <entry key="remote_ext_stopwords">words_location</entry> --> </properties> 下载密码:(访问密码:2822)

下载地址1立即下载

本站源码仅供个人兴趣学习

QQ: 3586696355

Q群: 530383698

QQ: 3586696355

Q群: 530383698

评论0